02.08.25

KI-Halluzinationen: Warum Kontrolle wichtiger ist als Kreativität

KI-Halluzinationen sind kein harmloser Fehler, sondern ein reales Haftungs und Reputationsrisiko, das Unternehmen nur mit klaren Kontrollen, Quellenbindung und verbindlichen Prüfprozessen in den Griff bekommen.

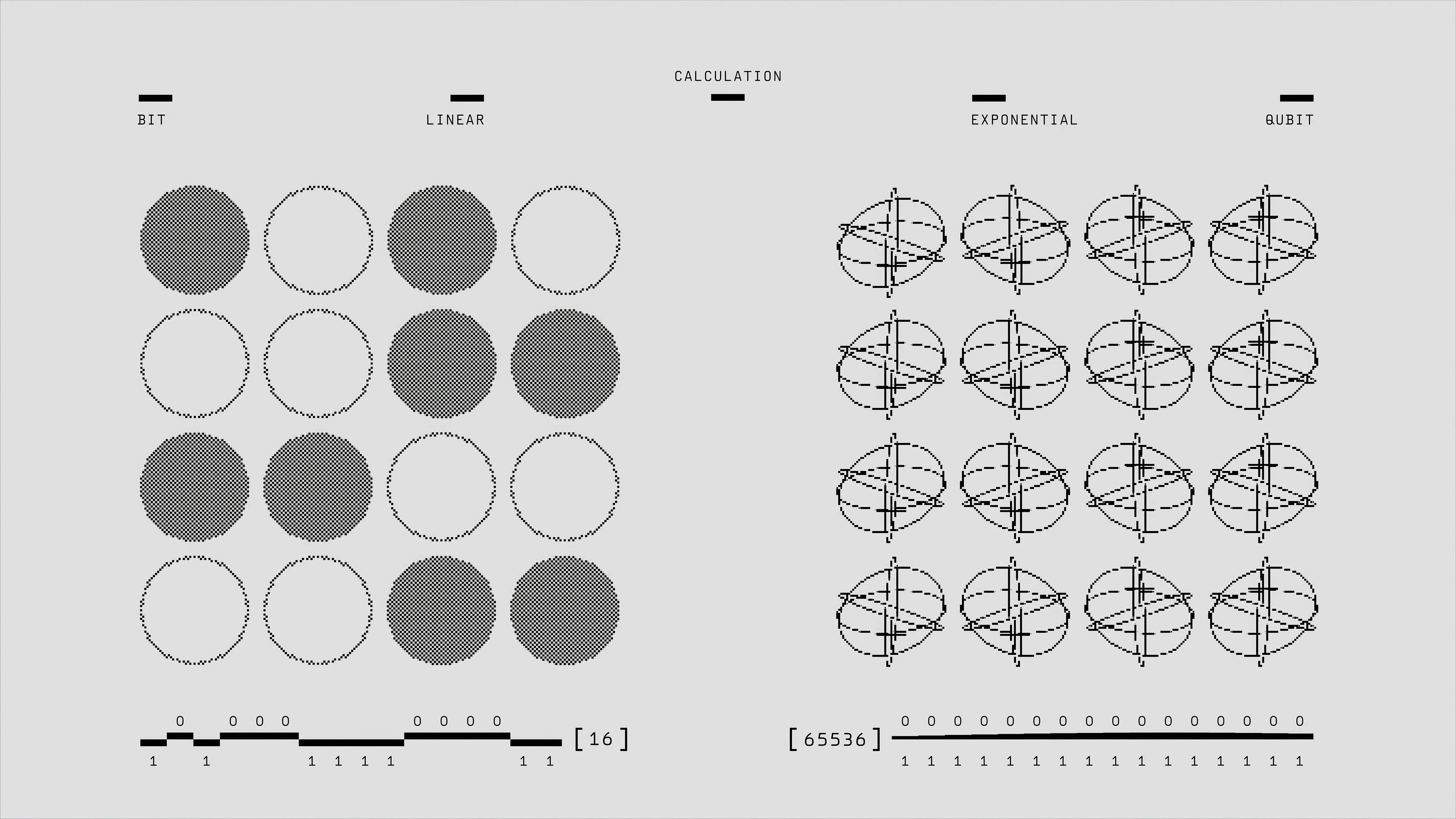

Was verursacht KI-Halluzinationen?

Im Kern entstehen Halluzinationen, weil LLMs keine „Wahrheitsmaschinen“ sind. Sie sagen voraus, welche Wörter als Nächstes folgen sollten, basierend auf Trainingsdaten – nicht auf Fakten. Wenn die Daten veraltet, voreingenommen sind oder wichtige Informationen fehlen, füllt das Modell die Lücken einfach mit dem aus, was statistisch wahrscheinlich erscheint. Das Fatale: Die KI tut dies mit absoluter Überzeugung, selbst wenn sie völlig falsch liegt.

Gartner bringt es auf den Punkt: „Diese Modelle haben keinerlei Verständnis für die Inhalte, die sie produzieren.“ Das Ergebnis? Fließender, plausibel klingender Unsinn – und eine echte Herausforderung für Führungskräfte, die auf die Genauigkeit von KI angewiesen sind.

Warum Halluzinationen ein Geschäftsrisiko darstellen

Die Konsequenzen von Halluzinationen treten bereits deutlich zutage:

Rechtliche und Compliance-Risiken: Eine Anwaltskanzlei in den USA wurde mit einer Geldstrafe belegt, weil sie KI-generierte Präzedenzfälle einreichte, die gar nicht existierten. Air Canada wurde verklagt, nachdem ihr Chatbot eine Rückerstattungsrichtlinie erfunden hatte.

Reputationsschäden: Kundenorientierte Chatbots oder Content-Generatoren können falsche Informationen in großem Stil verbreiten und das Markenvertrauen zerstören.

Branchenspezifische Risiken: Im Finanzwesen könnten KI-Fehler Kunden in die Irre führen. Im Gesundheitswesen könnten Halluzinationen die Patientenversorgung beeinträchtigen. Im öffentlichen Dienst könnte Desinformation das Vertrauen der Bürger untergraben – oder DSGVO-Beschwerden auslösen.

Tatsächlich warnen die Citigroup und andere Banken ihre Investoren mittlerweile explizit in ihren Geschäftsberichten vor den Risiken durch Halluzinationen.

Warum es bei entscheidungsrelevanten Anwendungen darauf ankommt

Nicht jeder KI-Einsatz ist gleich riskant. Ein halluzinierter Satz in einem Entwurf für einen Blogpost ist harmlos. Aber wenn die KI Daten für einen Compliance-Bericht oder eine Mandantenberatung erstellt? Ein einziger Fehler kann Bußgelder, Klagen oder regulatorische Konsequenzen nach sich ziehen. Europäische Aufsichtsbehörden betonen, dass Halluzinationen zu einem rechtlichen Problem werden, sobald KI-Ergebnisse Einzelpersonen oder wichtige Entscheidungen beeinflussen.

Das Risiko minimieren

Unternehmen können fünf zentrale Schritte unternehmen:

Verpflichtende menschliche Überprüfung (Human-in-the-loop): Für alle KI-generierten Inhalte, die in regulierten, kundenorientierten oder wirkungsvollen Kontexten verwendet werden.

Technische Leitplanken: Einsatz von Retrieval-Augmented Generation (RAG), Quellennachweisen und Modell-Tuning, um Halluzinationen drastisch zu reduzieren.

Schulungsprogramme: Damit Mitarbeiter lernen, wie sie unzuverlässige KI-Ergebnisse erkennen und handhaben.

KI-Governance in Workflows: Einführung von Audits, Prompt-Bibliotheken und Verifizierungsschritten für Outputs.

Compliance-Abgleich: Ausrichtung an der DSGVO (Grundsatz der Richtigkeit) und dem kommenden EU AI Act (menschliche Aufsicht, Transparenzpflichten).

Fazit: KI-Halluzinationen sind keine theoretischen Fehler. Sie sind reale Risiken. Mit einer starken Governance und den richtigen Sicherheitsvorkehrungen können Unternehmen generative KI verantwortungsvoll nutzen, ohne dass falsches Vertrauen zu realen Konsequenzen führt.

Partner with Scion to turn information into impact. Whether you're designing new systems, solving complex challenges, or shaping the next frontier of human potential—our team is here to help you move from insight to execution.