15.09.25

RAG, Guardrails und Grounding: Wie GenAI im Unternehmen kontrollierbar wird

RAG, Guardrails und Grounding sind zentrale Bausteine, um generative KI im Unternehmen verlässlich, regelkonform und kontrollierbar zu betreiben.

Das zentrale Problem generativer KI im Unternehmen ist nicht Kreativität, sondern Verlässlichkeit. Modelle formulieren überzeugend, auch wenn sie falsch liegen. In regulierten oder entscheidungsrelevanten Prozessen ist das kein Detail, sondern ein Risiko. Für viele Unternehmen geht es weniger um das Ob als um das Wie: GenAI muss so eingesetzt werden, dass sie kontrollierbar und verlässlich bleibt.

In den letzten zwei Jahren haben sich drei technische Ansätze als besonders wirksam erwiesen, um generative KI zuverlässiger und unternehmstauglich zu machen: Retrieval-Augmented Generation (RAG), Guardrails und Grounding.

1. Retrieval-Augmented Generation (RAG): Antworten auf Basis echter Daten

Ein zentraler Grund für Halluzinationen ist, dass Sprachmodelle Wahrscheinlichkeiten berechnen und nicht auf überprüfbare Fakten zugreifen. RAG setzt genau hier an.

Statt sich ausschließlich auf Trainingsdaten zu verlassen, ruft eine RAG-Architektur relevante Informationen aus definierten Datenquellen ab und stellt sie dem Modell im Prompt-Kontext zur Verfügung. Das können interne Richtlinien, Wissensdatenbanken oder strukturierte Unternehmensdaten sein. Das Modell „rät“ dann nicht mehr frei, sondern verarbeitet konkrete, geprüfte Inhalte.

In der Praxis bedeutet das:

Antworten basieren auf aktuellen Unternehmensdaten

Inhalte lassen sich auf Quellen zurückführen

Halluzinationen werden deutlich reduziert

RAG bringt jedoch zusätzliche Anforderungen mit sich. Daten müssen aktuell gehalten, sinnvoll indexiert und in klar definierten „Source of Truth“-Systemen organisiert werden. Ohne saubere Datenbasis skaliert auch RAG keine Verlässlichkeit.

2. Guardrails: Klare Grenzen für erlaubte Antworten

Selbst mit angebundenen Daten benötigen Modelle klare Regeln. Guardrails sind Kontrollmechanismen, die definieren, was ein System sagen oder tun darf und was nicht. Das können regelbasierte Prüfungen, Moderationsschichten oder definierte Antwortgrenzen sein. Ziel ist es, riskante oder unzulässige Ausgaben zu blockieren, bevor sie produktiv genutzt werden.

Typische Anwendungsfälle:

Verhindern von Anlageberatung in Finanzkontexten

Blockieren medizinischer Diagnosen

Filtern personenbezogener oder sensibler Inhalte

Sicherstellen markenkonformer Kommunikation

Guardrails dienen nicht nur der Sicherheit, sondern auch der Governance. Sie machen aus einem generativen Modell ein kontrolliertes Unternehmenssystem.

3. Grounding: Das Modell im Unternehmenskontext verankern

Sprachmodelle sind Generalisten. Für den produktiven Einsatz müssen sie in den fachlichen Kontext des Unternehmens eingebettet werden.

Grounding bedeutet, unternehmensspezifisches Wissen strukturiert zugänglich zu machen. Dazu gehören:

Einbindung proprietärer Dokumente und Richtlinien

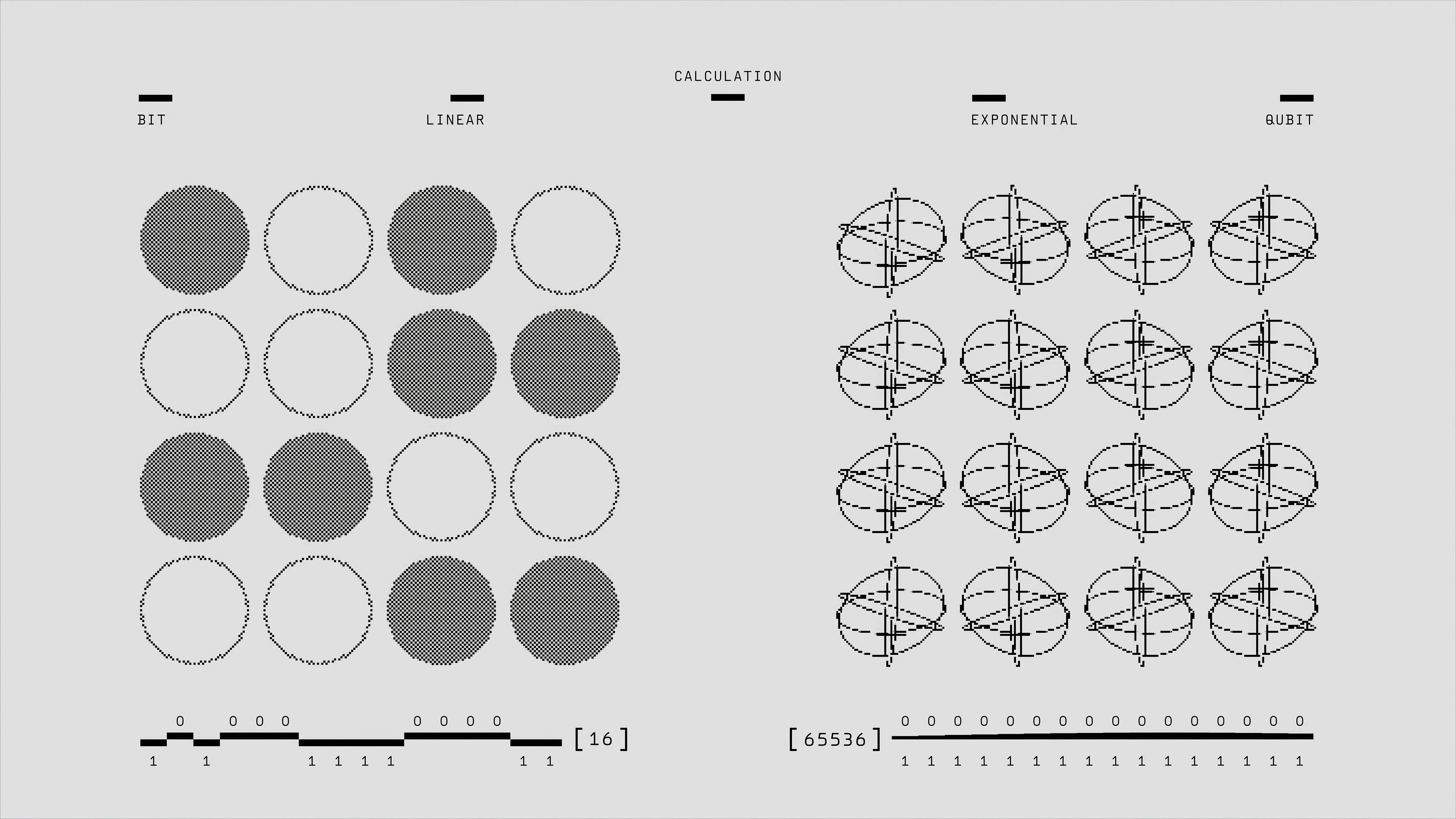

Strukturierung von Wissen über Vektor-Embeddings

Nutzung von Knowledge Graphs zur Abbildung von Zusammenhängen

Je klarer definiert ist, wo im Unternehmen die „Wahrheit“ liegt, desto stabiler wird das System. Grounding ist deshalb nicht nur eine technische Aufgabe, sondern erfordert Abstimmung zwischen IT, Fachbereichen und Compliance.

Warum das geschäftlich relevant ist

Zuverlässigkeit ist kein technisches Detail, sondern eine betriebliche Notwendigkeit.

Wenn GenAI in Entscheidungsprozesse eingebunden wird, hat sie direkten Einfluss auf:

Strategische Entscheidungen

Compliance-Anforderungen

Kundenkommunikation

Interne Wissensarbeit

Unkontrollierte Modelle erzeugen Unsicherheit. Kontrollierte Systeme schaffen Vertrauen und Akzeptanz im Unternehmen.

Praktische nächste Schritte

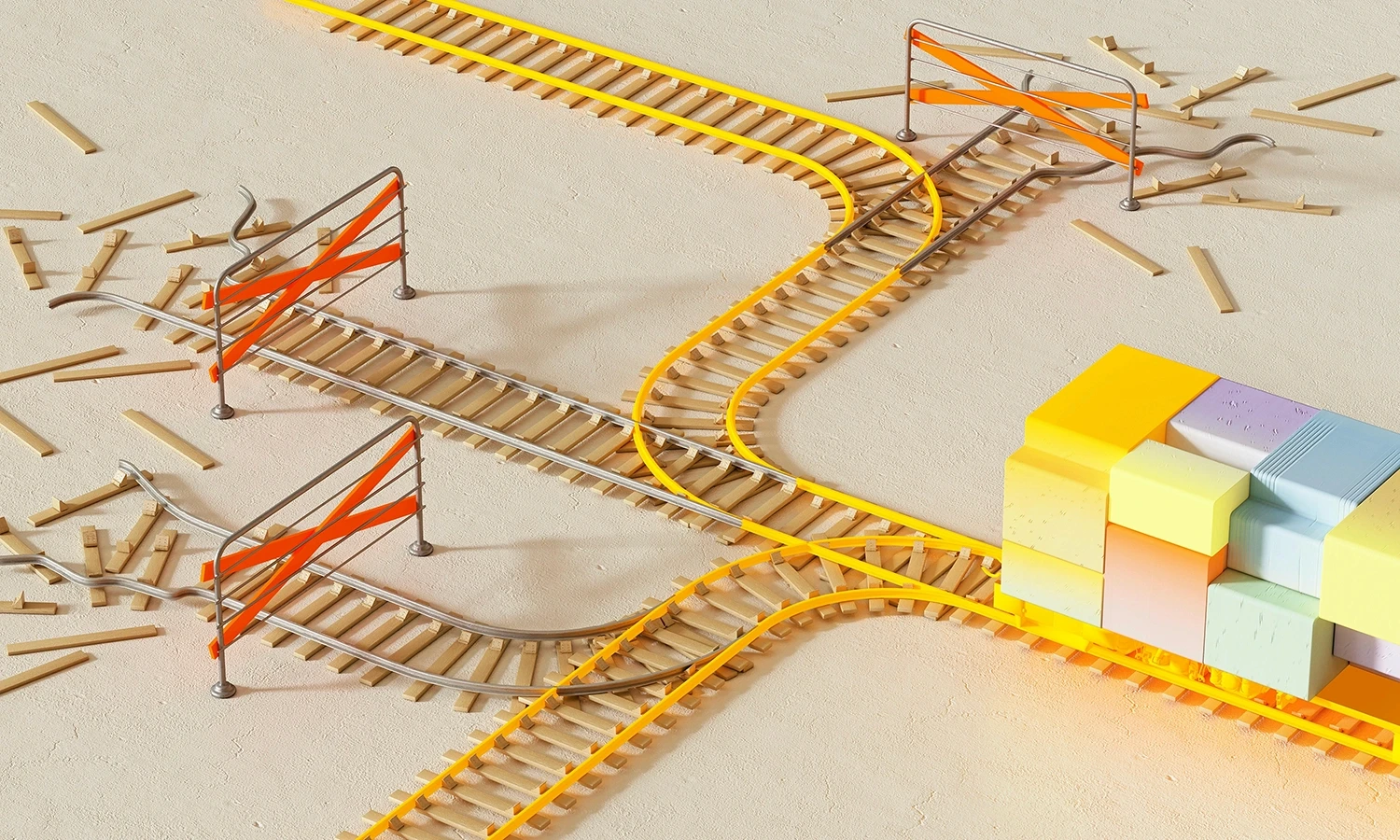

Für Organisationen, die GenAI produktiv einsetzen wollen, ergeben sich klare Prioritäten:

Genauigkeit vor Geschwindigkeit priorisieren.

Mit klar abgegrenzten RAG-Anwendungsfällen starten.

Guardrails frühzeitig definieren, nicht erst nach einem Vorfall.

Interne Wissensquellen systematisch als „Source of Truth“ strukturieren.

Fazit

Zuverlässige GenAI entsteht nicht automatisch. Sie ist das Ergebnis aus angebundenen Daten, klaren Regeln und sauber strukturiertem Unternehmenswissen.Wer diese Grundlagen ignoriert, skaliert Unsicherheit. Wer sie systematisch aufbaut, macht generative KI kontrollierbar und langfristig produktiv nutzbar.

Partner with Scion to turn information into impact. Whether you're designing new systems, solving complex challenges, or shaping the next frontier of human potential—our team is here to help you move from insight to execution.